Hoofdstuk 1

Vectoren dik gedrukt, scalairen normaal en Matrices in hoofdletters

Vector = een pijl in Rn. Een vector heeft een grootte en een richting. Dit in tegenstelling tot

een coördinaat, dat slechts één punt in Rn is, en dus ook geen grootte en richting heeft.

Coëfficiënten matrix = matrix waarin de rechterkolom geen oplossing van de vergelijking is

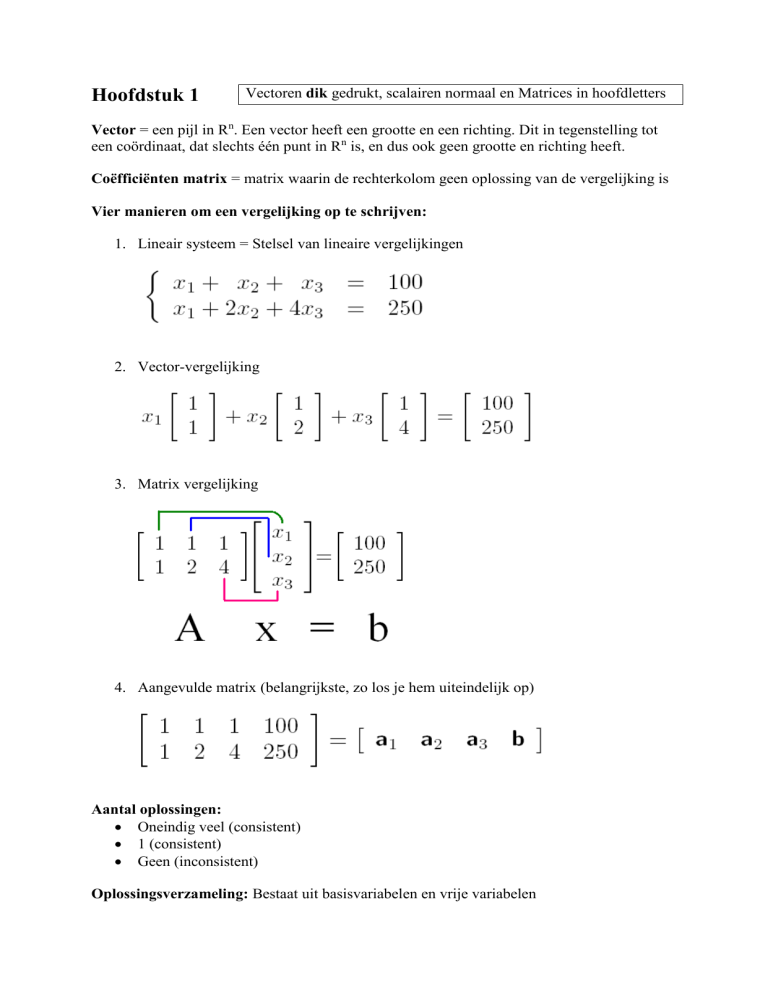

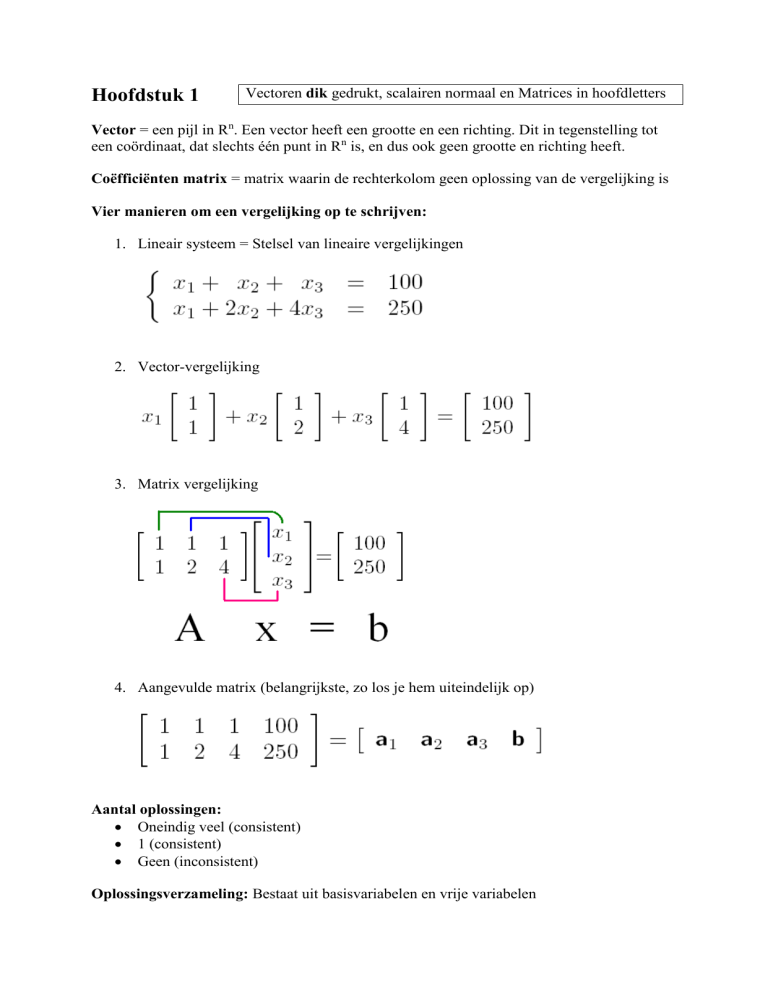

Vier manieren om een vergelijking op te schrijven:

1. Lineair systeem = Stelsel van lineaire vergelijkingen

2. Vector-vergelijking

3. Matrix vergelijking

4. Aangevulde matrix (belangrijkste, zo los je hem uiteindelijk op)

Aantal oplossingen:

Oneindig veel (consistent)

1 (consistent)

Geen (inconsistent)

Oplossingsverzameling: Bestaat uit basisvariabelen en vrije variabelen

3 elementaire rij-operaties bij een matrix

Vervangen

Vermenigvuldigen

Verwisselen

Standaard rijvorm

Alle niet-nul rijen boven de nulrijen

Elk hoofdelement ( = pivot, meest linkse niet nul element) zit in een kolom rechts van

het hoofdelement in de rij er boven

Alle elementen in een kolom onder het hoofdelement zijn nullen

Kanonieke (= gereduceerde) rijvorm heeft nog 2 eisen:

Het hoofdelement in elke niet-nul rij is gelijk aan 1

Elk hoofdelement is het enige niet-nul element in een kolom

Nulrij/nulkolom: rij/kolom met alleen maar nullen

Variabelen: x1, x2, … , xp

Basisvariabelen: x1 = 3

vrije variabelen: x1 vrij te kiezen

Algemene oplossing: Beschrijft alle oplossingen

Parametrische omschrijving: In de algemene oplossing worden vrije variabelen als

parameter gebruikt

Verzameling: {v1, v2, v3}

Opspansel: span {v1, v2, ... , vp} ,met v1, v2, ... , vp vectoren uit Rn, is een verzameling van alle

vectoren uit Rn die je kunt schrijven als c1 * v1 + c2 * v2 + … + cp * vp .

Dus: span {v1, v2, ... , vp} = c1 * v1 + c2 * v2 + … + cp * vp

b zit in span {v1, v2, ... , vp} als je b kunt schrijven als = c1 * v1 + c2 * v2 + … + cp + vp.

Dus om te kijken of b er in zit, moet c1 * v1 + c2 * v2 + … + cp * vp = b oplossingen hebben.

Dit los je op door c1 * v1 + c2 * v2 + … + cp * vp = b te beschouwen als vectorvergelijking.

Logisch equivalente beweringen: (zie aantekening voor uitleg!)

1. Voor elke b in Rm heeft de vergelijking Ax = b een oplossing

2. Elke b in Rm is een lineaire combinatie van de kolommen van A

3. De kolommen van A spannen Rm op

4. A heeft een pivot positie in elke rij

Rekenregels: Als A een m x n matrix is, u en v vectoren in Rn en c een scalair, dan

A(u + v) = Au + Av

A(cu) = cAu

Lineaire combinaties

x1*a1

Ax (= x1*a1 + x2*a2 + …)

Homogeen systeem: Ax = 0

Altijd de triviale oplossing x = 0

Soms zijn er niet-triviale oplossingen voor x (dan is er een vrije variabele in de

oplossingsverzameling van x aanwezig)

o Als er niet-triviale oplossingen zijn, dan is het systeem lineair afhankelijk

o Als er geen niet-triviale oplossingen zijn, dan is het lineair onafhankelijk

Niet-homogeen systeem: Ax = b

(DIT IS GEEN EERSTEGRAADS FUNCTIE!)

Heeft de oplossing x = [x1; x2; x3 …] (de puntkomma tussen de x-en betekent dat de xen eigenlijk onder elkaar moeten staan, maar dat is geen efficiënt papiergebruik). Door

op de plaatsen van x1, x2, x3 enz. de gevonden waarden (na het herleiden van de

aangevulde matrix) in te vullen, kun je x herschrijven tot x = [x1; x2; x3 …] = p + vh.

Hierbij is vh de niet-triviale oplossing van het homogeen systeem. p is een vector die

er voor zorgt dat de oplossing gaat gelden voor Ax = b. Geometrisch gezien zorgt p er

voor dat de oplossingsverzameling verschoven wordt. vh wordt ook wel de homogene

oplossing genoemd en p de particuliere oplossing.

De volgende dingen kunnen lineair afhankelijk zijn (controleren m.b.v. aangevulde matrices):

Matrix kolommen, als een kolom een veelvoud is van een andere kolom

Homogene systemen: Ax = 0

Verzamelingen: { v1, v2, ... , vp } = c1 * v1 + c2 * v2 + … + cp * vp = Ax = 0

o Verzameling S = { v1, v2, ... , vp } is ook lineair afhankelijk als geldt:

v2 = c * v1

Als één van de vectoren de nulvector is

Als er meer vectoren zijn dan rijen in een vector (dus p>n)

vp is een lineaire combinatie van andere vectoren (c1*v1 + c2*v2 = vp)

(lineaire combinatie, want bovenstaande is herschrijfbaar tot: Ax = b)

Transformatie T

T zet vector x om in vector b = T(x)

Hierbij gaat x van Rn naar Rm

Rn is het domein van T

Rm is het codomein van T

T(x) noemen we ook wel het beeld van x onder T ,dus T(u) is het beeld van u onder T

T(x) is het bereik van T = de verzameling van alle beelden onder T

Als een transformatie T(x) ervoor zorgt dat Rn in Rm wordt afgebeeld, dan heet T surjectief.

T(x) spant dan Rm op, oftewel de matrix die voor de transformatie zorgt moet dan Rm

omspannen, dus die moet in elke rij een pivot hebben. (controleerbaar met de 4 logisch

equivalente stellingen).

Officiële omschrijving: Een afbeelding T: Rn -> Rm heet surjectief (engels: “onto”) als

elke willekeurige vector b = T(x) in Rm het beeld is van MINSTENS 1 vector x in Rn.

Als de kolommen van A in T(x) = Ax lineair onafhankelijk zijn (dus geen niet-triviale

oplossingen voor Ax=0), heet T injectief.

Officiële omschrijving: Een afbeelding T: Rn -> Rm heet injectief (engels: “one-to-one”)

als elke willekeurige vector b in Rm het beeld is van HOOGUIT 1 vector x in Rn.

Soorten transformaties

Matrix transformaties (meest gebruikte). hiermee zet je met behulp van een matrix A

de vector x om in b, T(x) = Ax = b. Matrix transformaties zijn lineaire transformaties.

Soms heb je te maken met de transformatie T(x) = Ax en dan is A gevraagd, zodat je

T(x) voor elke willekeurige x kunt berekenen. Dan is er in zo’n vraag e1, e2 enz.

gegeven met bijbehorende T(e1), T(e2) enz. Dan A= [ T(e1) T(e2) … enz. ]

A heet dan de standaard matrix voor de lineaire transformatie T. Uitgebreide uitleg en

het bewijs van de stelling in de aantekening bij paragraaf 1.9

Lineaire transformaties: deze voldoen aan de volgende rekenregels:

o T(u+v) = T(u) + T(v) voor alle u, v in het domein van T (in Rn dus)

o T(cu+dv) = c*T(u) + d*T(v) voor alle u, v in het domein van T (in Rn dus)

o T(c*u) = c*T(u)

voor alle u alle c

o T(0) = 0

Geometrisch lineaire transformaties: dit zijn lineaire transformaties die beschreven

worden in een assenstelsel. De volgende dingen kunnen gebeuren:

o Een punt/vlak verschuiven (= schuiftransformatie). Dit kan met een

willekeurige matrix A ( T(x) = Ax ), maar ook met een scalair r ( T(x) = r*x ).

Als 0<r<1, dan wordt de afbeelding verkleind en dan spreek je van contractie.

Als r>1, dan wordt de afbeelding vergroot en dan spreek je van dilatie.

o Een punt verschuiven over een cirkel. Bijbehorende matrix op pagina 100.

o Een punt spiegelen, bijvoorbeeld in de x-as, de y as, de lijn y=x, de lijn y=-x of

de oorsprong. Bijbehorende standaardmatrices op pagina 101 van het boek.

o Een vlak projecteren op de x-as of y-as. Bijbehorende standaardmatrices op

pagina 103 van het boek.

De oplosmethode voor elektrische schakelingen leren (zie aantekeningen)

Hoofdstuk 2: Matrix Algebra

Rekenregels voor matrices:

A+B=B+A

(A + B) + C = A + (B + C)

A+0=A

r*(A + B) = r*A + r*B

(r+s)*A = r*A + s*A

r*(s*A) = (r*s)*A

A*B ≠ B*A

OPLETTEN DUS!

A*B = [A*b1 A*b2 A*b3 … A*bn] en B*A = [B*a1 B*a2 B*a3 … B*an]

Alle kolommen A*bn van matrix A*B zijn dus lineaire combinaties (Ax = b = A*bn)

Als A is een m x n matrix en B een n x p matrix, dan is AB een m x p matrix

Ak = A*A*A*…*A (bijv. A3 = A*A*A)

A(BC) = (AB)C

A(B+C) = AB + AC

(B+C)A = BA + CA

r(AB) = (rA)B = A(rB)

Im*A = A = A*In

LET OP DE VOLGORDE VAN A EN I en Im EN In

Als AB = AC, dan geldt NIET automatisch B=C

Als A*B = 0, dan geldt NIET automatisch A=0 of B=0

AT is de transpose van matrix A. We zeggen dan dat we matrix A transponeren. In matlab is

dit A’. Hiermee worden de rijen kolommen en de kolommen worden de rijen. Ook hiervoor

gelden een aantal rekenregels:

(AT)T = A

(A+B)T = AT + BT

(rA)T = r*AT

(ABC)T = CTBTAT

LET WEER OP DE VOLGORDE VAN A EN B

De inverse matrix van A is A-1. Dit is een unieke matrix. Matrices die geen iverse hebben

heten singulier. Matrices die wel een inverse hebben noemen we niet-singulier. Alleen

vierkante matrices kunnen geïnverteerd worden (A is dus een n x n matrix) en de inverse

matrix bestaat alleen wanneer A*A-1 = A-1*A = In

De inverse matrix van A vind je door de matrix [A I] te herleiden. Het resultaat wordt dan

[I A-1]. Nu kun je de oplossing zo aflezen uit het achterste gedeelte A-1.

Voor een 2x2 matrix is er nog een andere manier:

Als A = [a b

c d]

dan A-1 = 1/(ad – bc) * [d –b

-c a]

waarbij (ad – bc) = det A

(determinant van A)

Rekenregels m.b.t. inverse matrices:

Als Ax = b, dan x = A-1b (alleen als A-1 bestaat)

Als A inverteerbaar is, dan is A-1 ook inveerteerbaar

(AB)-1 = B-1A-1

(AT)-1 = (A-1)T (Als A inverteerbaar is, dan is AT ook inverteerbaar)

De volgende stellingen zijn logisch equivalent voor een n x n matrix A:

A is een inverteerbare matrix

A is rij-equivalent (~) aan In (dus A is te herleiden tot In)

A heeft n pivot posities (dit is een mooie controle op inverteerbaarheid)

Ax = 0 heeft alleen de triviale oplossing (geen vrije variabelen in A)

De kolommen van A vormen een lineair onafhankelijke verzameling

The lineaire transformatie T(x) = Ax is injectief (one-to-one)

Ax = b heeft minstens 1 oplossing voor elke b in Rn

De kolommen van A omspannen Rn

De lineaire transformatie T(x) = Ax beeld Rn af in Rn

Er is een matrix C zodat CA = I

Er is een matrix D zodat AD = I

AT is een inverteerbare matrix

Ook lineaire transformaties kunnen inverteerbaar zijn. Stel je transformeert x naar T(x) door

A*x, dan kun je T(x) terug transformeren naar x door T(x)*A-1 (A*x*A-1 = x)

Een elementaire matrix E is een matrix die ontstaat door één enkele elementaire rij-operatie

uit te voeren op een eenheidsmatrix. Omdat rij-operaties omkeerbaar zijn (en E dus weer terug

te schrijven is tot I) zijn alle elementaire matrices inverteerbaar. De inverse matrix E-1 is de

elementaire matrix die E terug transformeert naar I.

Het Leontief input-output model is een rekenmethode die in de economie wordt gebruikt om

de verdeling te bepalen van geproduceerde goederen:

Totale productie = Onderlinge vraag tussen bedrijven + vraag consument

x

=

Cx

+

d

Waarbij x de totale productie is, C de matrixvorm van de input-output tabel, en d de vraag van

de consument. Vaak wordt deze formule herschreven tot de vorm: (I-C)x = d , waardoor x

oplosbaar wordt. Hier staat namelijk gewoon Ax = b.

Bij benadering geldt: (I-C)-1 ≈ I + C + C2 + C3 + … + Cm als de waarden in de kolommen van

C kleiner zijn dan 1. Wanneer dan m naar oneindig gaat, nadert Cm de nul-matrix.

Voorbeeld Col A (Zie volgende bladzijde)

Een apart type opspansel is de deelruimte. Een deelruimte H voldoet aan de volgende eisen:

H bevat de nulvector

Voor elke willekeurige u en v, de som u + v ligt in deelruitme H

Voor elke willekeurige u en elke willekeurige scalair c, het product c*u ligt in H

Col A (“Kol A” in het Nederlands) is de kolomruimte van matrix A. Dit is de verzameling

van alle lineaire combinaties van de kolommen van A. Om te kijken of een bepaalde vector v

in Col A voorkomt, los je op: Ax = v. Is dit systeem consistent, dan zit v in Col A.

Col A: Als A = [a1 a2 … ], dan Col A = Ax = Span{ a1, a2, …} = x1*a1 + x2*a2 + …

De basis voor Col A bestaat uit de pivot kolommen van de originele matrix A, en dus

niet van de gereduceerde vorm van A

Nul A is de nulruimte van matrix A. dit is hetzelfde als de oplossingsverzameling van Ax = 0.

Om te kijken of een bepaalde vector v in Nul A voorkomt, moet je A*v uitrekenen en kijken

of dit de nulvector oplevert. Zo ja, dan zit v in Nul A, en anders niet.

Nul A = de oplossingsverzameling van Ax = 0

De basis voor Nul A bestaat uit de vectoren in de oplossingsverzameling van Ax = 0,

dus als Nul A = x3*u + x4*v, dan de basis voor Nul A = {u,v}

Een basis voor een deelruimte H van Rn is een lineair onafhankelijke verzameling in H die

H opspant. Dus je moet kijken of de gegeven kolommen lineair onafhankelijk zijn.

Logisch equivalente beweringen voor vierkante (n x n) matrices:

1. Voor elke b in Rm heeft de vergelijking Ax = b een oplossing

2. Elke b in Rm is een lineaire combinatie van de kolommen van A

3. De kolommen van A spannen Rm op (dus de kolommen zijn een basis voor Rm)

4. A heeft een pivot positie in elke rij

5. De kolommen van A zijn lineair onafhankelijk

6. A is een inverteerbare matrix

7. A is herleidbaar tot de identiteitsmatrix Im

Normaal gesproken ben je gewend om de coördinaten van een assenstelsel uit te drukken in

(x,y). Maar je kunt ook met vectoren werken, bijv. b1 en b2, die een opspansel of deelruimte

vormen. Een punt binnen deze deelruimte druk je dan uit in bijv. 3b1 en 2b2. Als je het punt x

uit wil drukken in vectoren, doe je dat met [x]B. Hierin is B de verzameling vectoren die de

basis van de desbetreffende deelruimte vormen. Hieronder een voorbeeld:

De dimensie van een m x n matrix A is {m n}.

Met de dimensie van een deelruimte H bedoelen we het aantal vectoren in de basis van H. De

nul deelruimte is nul (nulvector zorgt voor lineaire afhankelijkheid dus basis kan niet bestaan)

De rang van matrix A is de dimensie van Col A (dus het aantal vectorkolommen in Col A).

Dus: Rang A = dim Col A. Ook geldt voor m x n matrix A: dim Col A + dim Nul A = n

Hoofdstuk 3: De determinant

De determinant van een matrix is een getal dat vertelt of een matrix inverteerbaar is of niet.

Als det A (de determinant van A) gelijk is aan nul, dan is de matrix niet inverteerbaar. A heet

dan singulier.

Is de determinant ongelijk aan nul, dan is de matrix wel inverteerbaar. A heet dan nietsingulier.

Omdat alleen vierkante matrices inverteerbaar kunnen zijn, hebben ook alleen vierkante

matrices een determinant. Van een 1x1 en een 2x2 matrix kunnen we de determinant direct

berekenen.

Voor het berekenen van de determinant van grotere matrices bestaan 2 technieken:

cofactor ontwikkeling naar een bepaalde rij of kolom.

De matrix omschrijven tot de driehoeksmatrix. De determinant is vervolgens gelijk

aan het product van de getallen in de hoofddiagonaal. Denk met omschrijven aan de

rekenregels voor elementaire rij-operaties.

Tekenafspraak:

Driehoeksmatrices:

Andere notatie:

Enkele standaard determinanten:

1x1 matrix: det A = a

(met A = [a])

2x2 matrix: det A = ad – bc

Driehoeksmatrix: det A = Het product van de getallen op de hoofddiagonaal

Identiteitsmatrix: det In = 1

Matrix met twee dezelfde rijen: det A = 0

Matrix met nulrij: det A = 0

Matrix met nulkolom: det A = 0

det AT = det A

det A-1 = 1/(det A)

det (A*B) = (det A)*(det B)

det (A4) = (det A) * (det A) * (det A) * (det A)

LET OP: det (A+B) ≠ (det A) + (det B)

De determinant na elementaire rij-operaties:

Als de matrix B ontstaat door een veelvoud van een rij van A op te tellen bij een

andere rij, dan: det B = det A

Als B ontstaat door twee rijen van A te verwisselen, dan: det B = −det A

Als B ontstaat door een rij van A met k te vermenigvuldigen, dan: det B = k * det A

De determinant na kolom-operaties:

Als de matrix B ontstaat door een veelvoud van een kolom van A op te tellen bij een

andere kolom, dan: det B = det A.

Als B ontstaat door twee kolommen van A te verwisselen, dan: det B = −det A.

Als B ontstaat door een kolom van A met k te vermenigvuldigen, dan: det B= k*det A.

De lineariteit eigenschap van een determinant houdt in dat je de determinant kunt zien als een

lineaire functie van de kolom variabele. Verder geen idee wat je er mee kunt!

Regel van Cramer: xi = det Ai(b) / det A

met Ai(b) Matrix A waarbij de i-de kolom

vervangen is door b.

De geadjungeerde van Matrix A, genoteerd als adj A, is de matrix die uit cofactoren bestaat:

(Vraag 11 van paragraaf 3.3 bestuderen!)

In dit voorbeeld zijn de cofactoren voor linksboven en linksonder aangegeven. Let ook hier

weer op de tekenafspraak!

Enkele toepassingen van de determinant:

De oppervlakte van een parallellogram is de absolute waarde van de uitkomst van

de determinant van de vectoren van de 2 belangrijkste hoekpunten, dus: opp. = | det A

|. Hierbij is A dus een 2 x 2 matrix. Voorwaarde is wel dat 1 van de 2 onbelangrijke

hoekpunten de oorsprong is. Is dit niet zo, dan moet je het parallellogram verschuiven

zodat hij in de oorsprong komt.

Het volume van een blok wordt bepaald door de absolute waarde van de uitkomst van

de determinant van de vectoren van de 3 belangrijkste hoekpunten, dus volume = | det

A |. Hierbij is A dus een 3 x 3 matrix. Ook hier weer de voorwaarde dat 1 van de

hoekpunten de oorsprong is.

Hoofdstuk 6 en Stewart Hoofdstuk 12: vectoren in een ruimte Rn

Inproduct:

Lengte van een vector:

Een vector met lengte 1 heet een eenheidsvector (let op: ei heet óók een eenheidsvector)

De afstand tussen twee vectoren is ||u-v||:

Uitproduct (= kruisproduct):

Grafische voorstelling van het uitproduct:

Hieruit volgt: De vector u x v is orthogonaal tot zowel u als v.

Het uitproduct bestaat alleen voor vectoren in R3.

Als hoek θ nu 90° is, en u en v dus orthogonaal zijn, dan: u ∙ v = ||u|| ||v|| cos( ½π) = 0

Als hoek θ nu 0° is, en u en v dus parallel lopen, dan: u ∙ v = ||u|| ||v|| cos (0) = ||u|| ||v||

De verzameling van vectoren z die orthogonaal zijn tot vlak W, waarbij W omspannen wordt

door u en v, heet het orthogonaal complement van W en wordt genoteerd met W┴.

Als A een m x n matrix is, dan is het orthogonaal complement van de rijruimte van A de

nulruimte van A, en het orthogonaal complement van de kolomruimte van A is de nulruimte

van AT: (Rij A) ┴ = Nul A en (Kol A) ┴ = Nul AT

Rekenregels:

u∙v=v∙u

(u + v) ∙ w = u ∙ w + v ∙ w

(cu) ∙ v = u ∙ (cv)

u ∙ u ≥ 0 (behalve als u = 0 natuurlijk)

(c1*u1 + … + cpup) ∙ w = c1(u1 ∙ w) + … + cp(up∙ w)

|| cu || = c ||u||

u x v = -v x u

(cu) x v = c(u x v) = u x (cv)

u x (v + w) = u x v + u x w

(u + v) x w = u x w + v x w

u ∙ (v x w) = (u x v) ∙ w

u x (v x w) = (u ∙ w)v – (u ∙ v)w

Enkele toepassingen van in- en uitproduct:

De oppervlakte van een parallellogram dat wordt bepaald door u en v is gelijk aan

de lengte van het uitproduct van u en v, dus opp. = ||u x v||

Het volume van een blok dat wordt bepaald door u, v en w is gelijk aan | u ∙ (v x w) |

(De verticale strepen zijn absoluutstrepen)