&

FINANCE

CONTROL

Organisatie en processen

O mg a an m e t b i a s e s

VOORDAT DIE GROTE BESLISSING WORDT

GENOMEN…

Een grote investering. Een overname. Een ingrijpende aanpassing van de prijsstelling. In strategische beslissingen kunnen gevaarlijke biases kruipen. Hoe voorkom je dat?

DOOR DANIEL KAHNEMAN, DAN LOVELLO EN OLIVIER SIBONY

W

ie zijn vakliteratuur de laatste jaren een beetje heeft bijgehouden, weet dat allerlei vormen van bias de kwaliteit van

beslissingen negatief kunnen beïnvloeden. Denk aan bevestigingsbias, waarbij mensen focussen op informatie die bevestigt wat ze toch al dachten en informatie die dat tegenspreekt

wegwuiven. Of anchoring-bias (ankerbias of -heuristiek): als

mensen een bepaald getal of een bepaalde norm over iets krijgen, gebruiken ze dat vervolgens als ‘anker’, richtlijn, voor hun

oordeel of besluit daarover. De meeste managers zijn zich

inmiddels maar al te bewust van het gevaar van dit soort

denkfouten, maar dat heeft niet geleid tot betere zakelijke beslissingen – wijst de praktijk uit. Praten en lezen over bias is

mooi maar voorkomt niet dat er bias optreedt. Biases voorkom je alleen door concrete stappen in te bouwen in je besluitvorming. Dat is de moeite waard, blijkt uit onderzoek van

McKinsey naar meer dan duizend grote investeringen: organisaties die actief proberen om bias in hun besluitvorming uit te

bannen, halen tot 7 procentpunten meer rendement uit hun

investeringen.

Blind voor bias

Een probleem is dat mensen nauwelijks vat krijgen op hun eigen biases. Volgens de cognitieve wetenschap zijn er twee

‘modi’ van denken: intuïtief denken (systeem-1-denken, dat

snel is en moeiteloos en grotendeels onbewust plaatsvindt) en

reflectief denken (systeem-2-denken, dat veel trager verloopt,

inspanning vereist en bewust is). Het probleem is dat cogni-

40

|

tieve biases met name in systeem-1-denken sluipen – een proces dat ongemerkt plaatsvindt, óók als we ons er op zich bewust van zijn dat er biasgevaar is. Omdat systeem-1-denken

zo intuïtief en vluchtig is, merken we de denkfouten niet op.

We zijn blind voor onze eigen biases. We zijn echter niet blind

voor biases – bijvoorbeeld in diagnoses, evaluaties en rapportages – van anderen. Dat benaderen we namelijk via systeem2-denken: bewust, analytisch. Bij belangrijke beslissingen met

een hoog strategisch gehalte zijn beslissers vaak afhankelijk

van voorwerk (diagnose, evaluatie, proposal met aanbevelingen) door een team dat op de kwestie is gezet. Voor dit soort

beslissingen op basis van rapportages, proposals enzovoort

van anderen kunnen biases wel degelijk worden geëlimineerd.

Hoe doe je dat als beslisser?

Besliskwaliteitbeheersing

Bij voorstellen of aanbevelingen van teams die een bepaalde

kwestie hebben onderzocht als basis voor een belangrijke strategische beslissing, moet degene die het uiteindelijke besluit

neemt verschillende soorten vragen stellen (zie de checklist).

Ten eerste zijn er drie vragen die hij voor zichzelf moet stellen, om de simpele reden dat je dit niet aan de teamleden zelf

kunt vragen omdat dit te confronterend zou zijn. Is er op enigerlei wijze reden om te vermoeden dat er ‘gemotiveerde fouten’ in de aanbeveling zitten? Dat wil zeggen: fouten die er

(meestal onbewust maar niet altijd) in zijn gekomen vanuit

het eigenbelang van de aanbevelers. Natuurlijk zit er altijd een

OKTOBER 2011

&

FINANCE

CONTROL

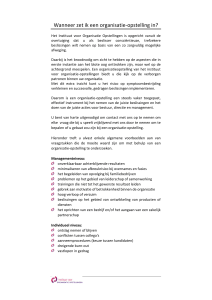

Checklist – Vragen die beslissers moeten stellen bij aanbevelingen en voorstellen

Deze checklist is niet bedoeld voor het soort kleine routinematige beslissingen die u alleen maar formeel hoeft af te stemmen, maar voor

belangrijke strategische beslissingen. Hoe meer de beslisser bij het

voorwerk betrokken was, hoe meer kans dat hij (al dan niet onbewust

zijn eigen bias aan analyses en aanbevelingen heeft toegevoegd – en

Vragen aan jezelf Voorbereidende vragen

1. Check op eigenbelangbiases

2. Check op de affectheuristiek

3. Check op groepsdenken

Vragen aan de aanbevelers Uitdagingsvragen

4. Check op saliency-bias

5. Check op bevestigingsbias

6. Check op (informatie)beschikbaarheidsbias

7. Check op ankerheuristiek

8. Check op halo-effect

daar bijgevolg blind voor is. Er moet daarom een duidelijke scheiding

zijn tussen de beslisser/biasbeoordelaar en het team dat het voorwerk

doet en de aanbevelingen opstelt. Essentieel voor effectieve decisionquality control: loop de hele checklist af – weersta de neiging om bepaalde vragen over te slaan.

Is er op enigerlei wijze reden om te vermoeden dat er fouten in de aanbeveling zitten

voortvloeiend uit eigenbelangen van teamleden?

Is het team verliefd geworden op zijn voorstel?

Waren er afwijkende meningen binnen het

team? Zijn die afwijkende gezichtspunten

nauwkeurig onderzocht?

Controleer het voorstel extra zorgvuldig, vooral op overoptimisme.

Zou het kunnen dat de diagnose te veel beïnvloed is door een te weinig relevante analogie

met een memorabel eerder succes?

Zijn er geloofwaardige alternatieven in overweging genomen?

Als je deze beslissing over een jaar weer zou

moeten nemen, welke informatie zou je dan

willen hebben? Kun je nu al aan meer van die

informatie komen?

Weet je waar de cijfers vandaan kwamen? Kan

het … dat er onbevestigde cijfers bij zijn? …

dat ontwikkelingen uit het verleden zijn geëxtrapoleerd? … dat er een reden is om een bepaald anker te gebruiken?

Gaat het team ervan uit dat een persoon, organisatie of aanpak die succesvol is op een

bepaald gebied even succesvol zal zijn op een

ander gebied?

Zijn de aanbevelers te sterk gehecht aan beslissingen uit het verleden?

Vraag om meer analogieën en analyseer rigoureus in hoeverre die op de huidige situatie

lijken.

Vraag om meer opties.

9. Check op historische-kostenvalkuil/endowmenteffect

Vragen over de proposal Evaluatievragen

10. Check op te veel zelfvertrouwen, onder- Is de basiscase te optimistisch?

schatting van de planning en veronachtzaming van concurrenten

11. Check op verliesvermijding

Is het aanbevelende team te voorzichtig?

12. Check op onachtzaamheid voor rampen

Is de worst-case erg genoeg?

zekere voorkeur voor bepaalde uitkomsten in aanbevelingen,

dat is op zich niet zo erg. Maar als de groep aanbevelers opvallend veel baat heeft bij een bepaalde uitkomst – in financiele zin of, wat vaker voorkomt, in termen van macht, reputatie of carrièremogelijkheden binnen de organisatie – evalueer

de aanbeveling dan uiterst zorgvuldig op biases. Pas ook op

als het team meerdere opties geeft waarvan slechts één alterOKTOBER 2011

Voer rigoureus alle kwaliteitscontroles op deze

checklist uit.

Vraag om afwijkende zienswijzen (al dan niet

op discrete wijze).

Gebruik checklisten met de gegevens die nodig zijn voor elk soort beslissing.

‘Heranker’ met cijfers die uit andere modellen

of benchmarks voortkomen, en vraag om een

nieuwe analyse.

Elimineer verkeerde gevolgtrekkingen en vraag

het team om te zoeken naar aanvullende vergelijkbare voorbeelden.

Bekijk deze kwestie alsof je een pas aan gestelde CEO bent.

Laat het team een case opbouwen vanuit een

extern gezichtspunt; werk met war-games.

Pas de incentives zo aan dat de verantwoordelijkheid voor eventuele mislukkingen wordt

gedeeld of dat een bepaald risiconiveau wordt

geaccepteerd door de organisatie.

Laat het team een ‘pre-mortem’ doen.

natief echt realistisch is – namelijk de optie waar het team een

voorkeur voor heeft.

Een andere vraag is in hoeverre het aanbevelende team verliefd is op zijn aanbeveling. Als mensen zeer hechten aan de

aanbevolen uitkomst, zijn ze namelijk geneigd om de risico’s

en kosten daarvan te bagatelliseren en de voordelen ervan op

te leuken. Als teamleden op de een of andere manier emotio|

41

W W W. F I N A N C E - C O N T R O L . N L

&

FINANCE

neel zijn over hun aanbevelingen – in plaats van neutraal –

wees dan op je hoede. De laatste vraag die de beslisser voor

zichzelf moet stellen, is of er afwijkende meningen en zienswijzen binnen het team waren. En, zo ja, of daar voldoende

op is ingegaan: zijn de afwijkende gezichtspunten nauwkeurig

onderzocht? Waar het om gaat, is of er bij het opstellen van de

aanbeveling sprake was van groepsdenken. Of van een dominante teamleider die zijn eigen zin doordreef. Wees gealarmeerd als er geen afwijkende meningen binnen het team zijn:

100% unanimiteit is verdacht.

‘What you see is all there is’

Vervolgens zijn er zes vragen die de beslisser aan de teamleden moet stellen. Een belangrijke vraag is of de diagnose mogelijk te sterk beïnvloed is door analogieën met memorabele

eerdere successen. Mensen refereren in hun aanbevelingen

graag aan een saillant succes uit het verleden – ‘zo is dat toen

ook aangepakt en kijk eens wat dat opleverde…’ – om de beslisser te overtuigen. Er is echter een goede kans dat de aangevoerde analogie minder relevant is dan op het eerste gezicht

Biases voorkom je alleen door

concrete stappen in te bouwen in je

besluitvorming

lijkt. Bij het geringste vermoeden op dergelijke saliency-bias

moet de executive het team vragen om meer analogieën,

waarbij de relevantie (‘vergelijkbaarheid’) van de aangevoerde

voorbeelden ook grondig wordt geanalyseerd.

Een andere vraag is of het team geloofwaardige alternatieven

objectief en op feiten gebaseerd heeft onderzocht. Zo nee, dan

is er een goede kans op bevestigingsbias in de aanbevelingen.

Ook moet de beslisser uitzoeken in hoeverre het team in de

WYSIATI-val is gelopen: What you see is all there is. Omdat

onze intuïtieve geest een coherent verhaal construeert op basis van het bewijsmateriaal dat er is, zijn we blind voor de gaten en de ontbrekende informatie (die we onbewust ‘dicht’

redeneren en interpreteren). We zien niet meer wat er mist.

Aanbevelingen en voorstellen kunnen op ankerheuristiek

worden gecheckt door vragen te stellen als: Welke cijfers zijn

feiten en welke cijfers zijn inschattingen? Zijn deze inschattingen gemaakt door andere cijfers aan te passen? Wie kwam

met het eerste cijfer? In het bedrijfsleven komen drie soorten

ankerheuristiek vaak voor: aanvankelijke inschattingen (vaak

nattevingerwerk) worden nooit goed gecontroleerd en gaan

een eigen leven leiden; inschattingen worden gebaseerd op extrapolatie van cijfers uit het verleden; er worden doelbewust

42

|

CONTROL

te lage of te hoge ankers uitgeworpen (zoals een afnemer die

de onderhandelingen met een erg laag bod inzet).

Daarnaast moet de beslisser met het team praten over mogelijke aanwezigheid van zogeheten halo-effecten (waarbij wordt

aangenomen dat een persoon, onderneming of praktijk die op

een bepaald gebied succesvol was dan ook wel succesvol zal

zijn op een ander gebied), van de sunk cost-denkfout (waarbij

we opties evalueren in het licht van beslissingen of investeringen uit het verleden) en van endowment-effecten (mensen

kennen een hogere waarde toe aan dingen die ze in bezit hebben dan aan dingen die ze niet in bezit hebben).

Het derde en laatste type vragen die beslissers moeten stellen,

dient om de aanbeveling of proposal te evalueren. Is de basiscase te optimistisch? De meeste aanbevelingen bevatten prognoses, en we weten allemaal dat die nogal eens – maar niet altijd! – te optimistisch zijn. Dat komt doordat teams, vooral als

ze een goede staat van dienst hebben, vaak te veel zelfvertrouwen hebben. En doordat ze vaak de uitvoering van plannen onderschatten, die meestal complexer is dan gedacht. En doordat

ze vaak niet in aanmerking nemen hoe concurrenten reageren

op de beslissing. Zeg maar: als je voor een structurele prijsverlaging kiest, houd er dan wel rekening mee dat concurrenten

misschien een prijsoorlog starten. Het tegenovergestelde moet

ook worden bekeken: is het team te voorzichtig met zijn aanbevelingen? Overdreven conservatisme leidt tot gebrek aan creativiteit en ambitie – het is in veel organisaties de oorzaak van

chronische underperformance. Behoudzucht is lastig te bestrijden – maar het kan wel natuurlijk.

De laatste vraag is of de onderzochte worst case slecht genoeg

was. Meestal niet, wijst de praktijk uit. Doorgaans zijn er nog

veel ergere dingen die kunnen gebeuren maar die het team –

al dan niet bewust – over het hoofd ziet. Een probate techniek

op dit vlak is het ‘pre-mortem’, het omgekeerde van een postmortem(onderzoek). De premortemdeelnemers projecteren

zichzelf naar de toekomst, stellen zich voor dat het allerergste

is gebeurd wat kon gebeuren, en bedenken een verhaal over

de oorzaken van deze echte worst case.

Daniel Kahneman is senior wetenschapper aan de Woodrow

Wilson School of Public and International Affairs (Princeton University) en partner bij adviesbureau The Greatest Good. In 2002

won hij de Nobelprijs in Economische Wetenschappen voor zijn

onderzoek (samen met Amos Tversky) naar cognitieve biases.

Dan Lovello is hoogleraar bedrijfsstrategie aan de University of

Sydney. Olivier Sibony is een director van McKinsey in Parijs.

Harvard Business Review

June 2011

Titel: Before you make that big decision…

Samenvatting: drs. E. Kerkman

OKTOBER 2011