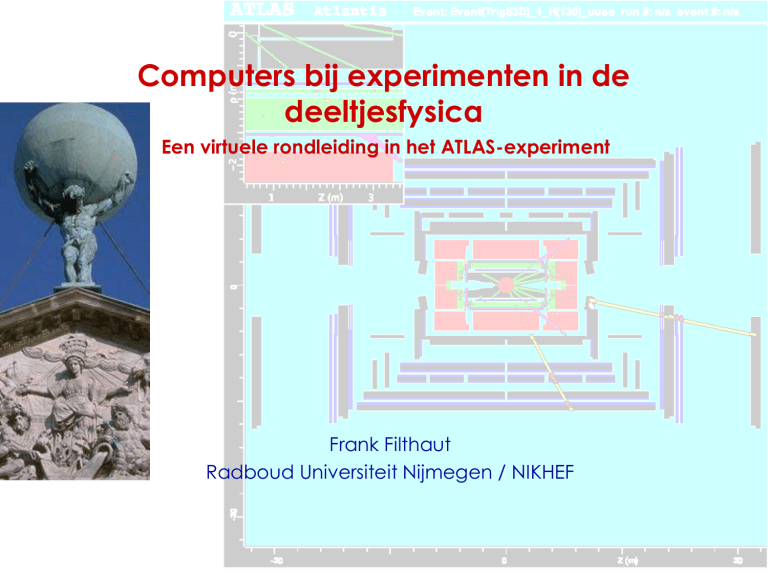

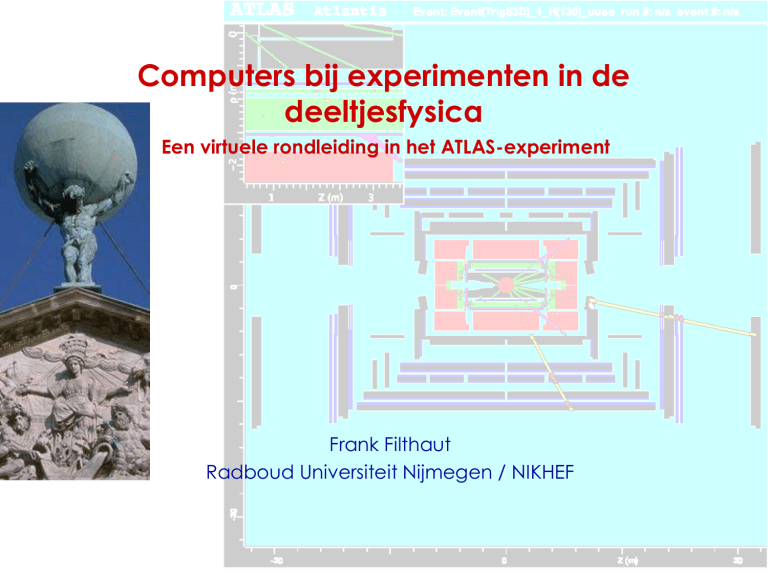

Computers bij experimenten in de

deeltjesfysica

Een virtuele rondleiding in het ATLAS-experiment

Frank Filthaut

Radboud Universiteit Nijmegen / NIKHEF

Inhoud

• Doelstellingen en methodes in de deeltjesfysica

• Triggers en data-acquisitie

• Reconstructie en analyse van data

25-10-2005

TU/e

2

Wat is deeltjesfysica?

• Doelstellingen:

– Erachter komen wat de

fundamentele bouwstenen

van materie zijn: elementaire

deeltjes

– De interacties tussen deze

deeltjes kunnen beschrijven

• Links met andere takken van

wetenschap / technologie:

– Astronomie (kosmologie,

kernfysische processen in

sterren)

– Spin-off (medische industrie,

WWW, Grid …)

25-10-2005

TU/e

3

Elementaire deeltjes

• Quarks komen niet vrij in de

natuur voor, maar alleen in

de vorm van hadronen

(gebonden toestanden van

quarks en/of antiquarks)

• Leptonen komen wel vrij voor,

maar alleen het elektron is

echt stabiel. Neutrino’s zijn

ongeladen en zijn bij

versneller-experimenten niet

waarneembaar

• Er is geen interactie “op

afstand”: interacties worden

overgebracht door

krachtdeeltjes

25-10-2005

TU/e

4

Waarom hoge-energiefysica?

• Van de op de vorige pagina genoemde fermionen zijn alleen

het elektron en de up- en down-quarks in “gewone” materie

aanwezig: de andere deeltjes zijn zwaar (mt = 175 GeV/c2, even

zwaar als een goud-atoom) en vervallen zeer snel (naar lichtere

deeltjes)

• Hoge energieën zijn nodig om deze zware deeltjes te kunnen

produceren

25-10-2005

TU/e

5

Deeltjesversnellers en botsingen

(Extreem) voorbeeld: de

Large Hadron Collider

(LHC) bij CERN

• botsingen tussen

protonen met

energieën van 7 TeV)

• Snelheid van de

protonen:

v = 0,99999991 c

• Detectie van bij de

interacties

vrijkomende hoogenergetische deeltjes

mbv gespecialiseerde

detectoren (bv ATLAS)

25-10-2005

TU/e

6

Complexiteit van experimenten

25-10-2005

TU/e

7

Detectie van deeltjes

• Particle interactions in the CMS experiment

25-10-2005

TU/e

8

Selectie van fysische processen

• De luminositeit (~intensiteit) van

de LHC-bundels moet tenminste

1033 cm-2 s-1 worden

– 108 interacties per seconde!

– Met 4·107 bundelbotsingen per

seconde: meerdere interacties

per bundelbotsing

• Fysisch “interessante” interacties

per seconde:

– 101 voor W-boson productie

– 10-2 voor “lichte” Higgs-bosonen

Een snelle (real time) selectie

van de interessante processen is

cruciaal!

25-10-2005

TU/e

9

Selectie van fysische processen (2)

• In werkelijkheid zien de

interacties er veel

gecompliceerder uit dan zoals

gesuggereerd door de

voorgaande ATLAS-simulatie!

– Honderden geladen deeltjes

iedere 25 ns

– Langzame signalen in de

calorimeters: overlap tussen

signalen van verschillende

bundelbotsingen

• Voor preciese metingen zijn

veel meetelementen nodig

– Tracking: ~ 50 m

ruwweg 107 elementen

In termen van “ruwe” data: ~ 10 TB/s. Een on-line selectie is nodig

om dit te reduceren tot ~ 200 MB/s (200 interacties / s)!

25-10-2005

TU/e

10

Triggers

• Van “triviale” situaties…

– Geen uitlezing tijdens

signaalverwerking:

“dead time”

• via extra buffering…

– Geen uitlezing als buffers

vol zijn

• en synchronisatie met de

bundelbotsingen…

– Gebruik van triggers

voornamelijk om

oninteressante

interacties te verwerpen

• naar de LHC-situatie

– Elektronische “pipelines”

25-10-2005

TU/e

11

Tijdsschalen en telsnelheden

• Detectorgegevens

zijn te complex om

de selectie in een

keer te maken

• Strategie: gooi eerst

snel de duidelijke

“rotzooi” weg, zodat

er meer tijd overblijft

om naar de

moeilijker gevallen

te kijken

– Typisch 3 niveaus

Digitalisatie (en “zero suppression”) van

gegevens gebeurt pas na een 1e niveau trigger

25-10-2005

TU/e

12

Een beslissing iedere 25 ns

• Houd het simpel en lokaal! Alleen calorimetrie, muonen.

• Intensief gebruik FPGA’s, PPCs (berekeningen), Gb/s links

(communicatie)

• 1e niveau trigger-beslissing op basis van simpele AND/OR regels

25-10-2005

TU/e

13

On-line data-reconstructie

• De uiteindelijke (3e niveau) trigger-beslissing wordt genomen op

basis van informatie van de gehele detector (calorimetrie,

muonsysteem, tracking)

• Probleem: hoe de gegevens van verschillende gedeeltes van de

detector in één computer to verzamelen?

• Typisch ~ 1 sec/interactie

voor 3-3.5 kHz input

rate zijn 1600 (Linux) dual

CPU PCs nodig!

• Uitgebreid onderzoek

nodig naar bruikbare

switches (Gb/s poorten,

intern ~100 Gb/s), en

optimum gebruik hiervan

(tcp/udp, ATM, …):

“traffic shaping”

• Uitgebreide monitoring

25-10-2005

TU/e

14

Reconstructie van interacties

We hebben de interessantie interacties geselecteerd. Wat nu?

• Taak van een reconstructieprogramma: een zo goed

mogelijke benadering geven

van de deeltjes die in de

interactie geproduceerd

werden

• Voorbeeld: reconstructie

van de trajecten van

geladen deeltjes:

– Patroonherkenning

– Bepalen van richting en

impuls

• Andere taken (“objecten”):

– e±,,±

– Jets (groepen hadronen ~

quarks/gluonen)

25-10-2005

TU/e

15

Patroonherkenning

• Met name het associëren van individuele “hits” (signalen

achtergelaten in meetelementen) met trajecten van geladen

deeltjes is een moeilijke taak:

– Inefficiënties (missende hits), elektronische ruis (extra hits)

– Alle combinaties van gemeten hits nagaan (~ N!) is onbegonnen

werk!

• Twee verschillende soorten algoritme om dit probleem op te

lossen. Lokale algoritmes:

– Begin met hits in de buitenste

laag van de tracking-detector,

definieer mogelijke trajecten

– Als binnen deze begrenzingen

inderdaad hits gevonden worden

in de laag daarbinnen, kan dit

gebruikt worden voor scherpere

begrenzingen

– NB: in de praktijk is dit geen 2D

maar een 3D probleem!

25-10-2005

TU/e

16

Patroonherkenning (2)

• Ook globale algoritmes (die alle hits in een keer beschouwen)

zijn mogelijk

– Voorbeeld: de Hough-transformatie “vertaalt” iedere hit naar een

hyper-oppervlak in de ruimte van mogelijke parameters van

trajecten van geladen deeltjes

– 2D: 2 parameters als alleen

rechte lijnen beschouwd

worden (bekijk Duality applet)

of als verondersteld kan

worden dat (binnen de

resolutie) alle deeltjes uit het

interactiepunt komen

aantal operaties ~ Nhit · Nbin

– 3D: 5 parameters in het meest

algemene geval. In de praktijk

is een 2D benadering (waarbij

3D parameters bepaald

worden mbv extra zinformatie) afdoende

Uiteindelijk wordt vaak een combinatie van algoritmes gebruikt

25-10-2005

TU/e

17

Patroonherkenning (3)

• Als alle geladen deeltjes

gevonden zijn, zijn we nog niet

klaar: deze kunnen gebruikt

worden om “lang” levende

deeltjes te identificeren

– B 1,5 ps, 0,3 ps

– Gemiddeld afgelegde afstand

voor verval: c

– Voor voldoende hoge

impulsen: ~ mm (goed te zien

door preciese extrapolatie van

trajecten)

• Ook hier is patroonherkenning

nodig:

– welke trajecten horen bij het

interactiepunt

– welke zijn compatibel met

“displaced vertices”

25-10-2005

TU/e

18

Data-productie

• Verwachtingen t.a.v. reconstructie van interacties:

– 15 kSI2k-s / interactie (1 kiloSpecInt-2k ~ 1 PC uit 2004)

– Met 200 Hz “interessante” interacties: 3000 PCs nodig (als data slechts

eenmaal gereconstrueerd hoeven te worden)!

• Calibratie en uitlijnen

van de diverse

meetelementen: een

iteratief proces

Higgs-deeltje, mH=130 GeV/c2

• Simulatie van fysische

interacties en van de

respons van de detector

voor deze interacties:

• ~ 20% van het aantal

data-interacties…

• maar 100 s / interactie!

25-10-2005

TU/e

19

Data-productie (2)

• Dezer dagen is het niet meer redelijk al deze rekenkracht op

CERN zelf te stationeren… het alternatief is een tiered systeem

CERN

Tier 0

~ 75 MB/s/T1

Tier 1

(x10)

NL

UK

USA

~ Gb/s links

Tier 2

•

•

•

Primaire reconstructie, calibratie, opslag ruwe data (5PB/jr): CERN

Re-reconstructie, simulatie, opslag ruwe/gereconstrueerde data (2PB/jr):

tier-1 centra (~ 2000 PCs)

Simulatie, data-analyse, opslag compacte data: tier-2 centra (~ 200 PCs)

25-10-2005

TU/e

20

Data-analyse: software

• Uiteindelijke fysica-resultaten: uit het (herhaald, iteratief)

bestuderen van (gedeeltes van) de data

– Met behup van computerprogramma’s!

• Het bestuderen van ~ 109 opgeslagen interacties / jaar is niet

triviaal!

– Alle code op basis van C++ (object orientation, dynamische

geheugen-allocatie, beschikbaarheid betrouwbare compilers, …)

– Uitgebreid software-management om efficiënte software-ontwikkeling

mogelijk te maken (CVS, indeling in pakketten): ~ 106 regels code

• Oplossing: begin met een

snelle pre-selectie

– Rudimentaire eigenschappen

van interacties bekend uit

reconstructie

– Opgeslagen als metadata in

een relationele DB (à la

ORACLE), met verwijzingen

naar (random access) data

25-10-2005

Eisen aan

dataset

Metadata DB

collecties

gegevens in

bestanden

TU/e

21

Data-analyse: het Grid

• Het ATLAS-experiment alleen al telt ~ 2000 fysici

– En dit is maar een van de 4 LHC-experimenten

– Onmogelijk om alle analyse van gegevens op CERN te doen

– Niet nieuw: het World Wide Web is op CERN ontwikkeld juist om

adequate communicatie tussen collega’s mogelijk te maken

• Oplossing: maak data-analyse zoveel mogelijk gedistribueerd

• Het Grid:

– Gebruikers specificeren

applicatie / dataset

– Op basis hiervan wordt een

“execution site” gekozen

– Applicatie-software wordt

gecopieerd

– Benodigde (en nog niet

aanwezige) data worden

transparant gecopieerd

– Resultaten worden naar de

gebruiker gestuurd

25-10-2005

TU/e

22

Tot slot…

• Er zijn legio onderwerpen waarvoor geen/onvoldoende tijd is ze

hier te behandelen:

– Mogelijke (interessante) fysische processen, fysica-analyse (volg een

college deeltjesfysica!)

– Samenwerkingsaspecten (videoconferencing, mailing lists,

documentatie, …)

– Signaalverwerking

• De LHC-versneller draait nog niet! Over ~ 2 jaar zullen we zien

hoe realistisch deze vooruitzichten zijn. Wellicht zien we een van

de volgende dingen:

– Het Higgs-boson

– Donkere materie

(SuperSymmetrie)

– Extra dimensies

25-10-2005

TU/e

23