Samenvatting Processorarchitectuur - martenserver.com

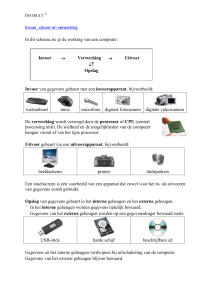

advertisement