Hoofdstuk 1 Vectoren dik gedrukt, scalairen normaal en Matrices in hoofdletters

Vector = een pijl in Rn. Een vector heeft een grootte en een richting. Dit in tegenstelling tot

een coördinaat, dat slechts één punt in Rn is, en dus ook geen grootte en richting heeft.

Coëfficiënten matrix = matrix waarin de rechterkolom geen oplossing van de vergelijking is

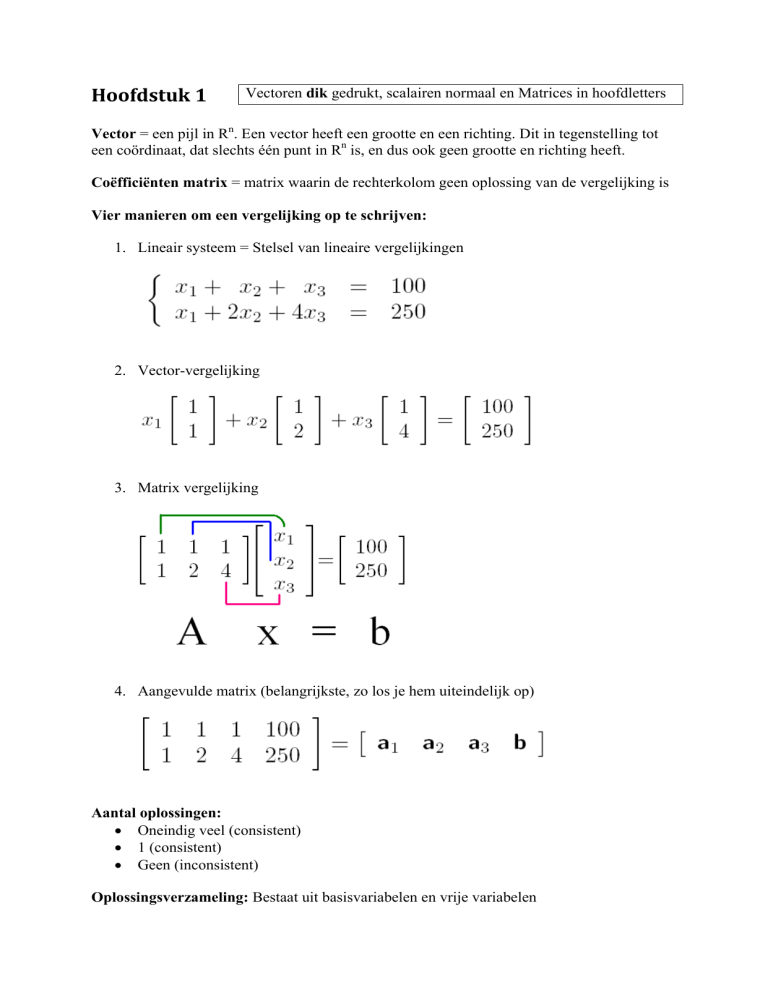

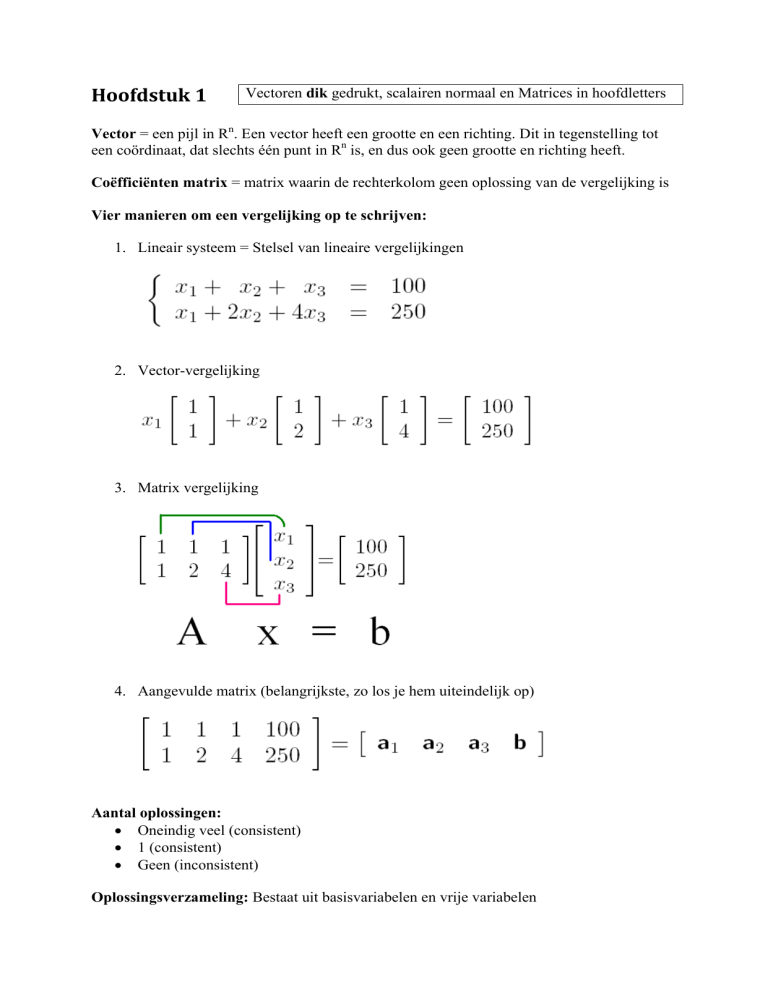

Vier manieren om een vergelijking op te schrijven:

1. Lineair systeem = Stelsel van lineaire vergelijkingen

2. Vector-vergelijking

3. Matrix vergelijking

4. Aangevulde matrix (belangrijkste, zo los je hem uiteindelijk op)

Aantal oplossingen:

• Oneindig veel (consistent)

• 1 (consistent)

• Geen (inconsistent)

Oplossingsverzameling: Bestaat uit basisvariabelen en vrije variabelen

Variabelen: x1, x2, … , xp

• Basisvariabelen: x1 = 3

• vrije variabelen: x1 vrij te kiezen

3 elementaire rij-operaties bij een matrix

• Vervangen

• Vermenigvuldigen

• Verwisselen

Standaard rijvorm

• Alle niet-nul rijen boven de nulrijen

• Elk hoofdelement ( = pivot, meest linkse niet nul element) zit in een kolom rechts van

het hoofdelement in de rij er boven

• Alle elementen in een kolom onder het hoofdelement zijn nullen

Kanonieke (= gereduceerde) rijvorm heeft nog 2 eisen:

• Het hoofdelement in elke niet-nul rij is gelijk aan 1

• Elk hoofdelement is het enige niet-nul element in een kolom

Nulrij/nulkolom: rij/kolom met alleen maar nullen

Algemene oplossing: Beschrijft alle oplossingen

Parametrische omschrijving: In de algemene oplossing worden vrije variabelen als

parameter gebruikt

Verzameling: {v1, v2, v3}

Opspansel: span {v1, v2, ... , vp} ,met v1, v2, ... , vp vectoren uit Rn, is een verzameling van

alle vectoren uit Rn die je kunt schrijven als c1 * v1 + c2 * v2 + … + cp * vp .

Dus: span {v1, v2, ... , vp} = c1 * v1 + c2 * v2 + … + cp * vp

b zit in span {v1, v2, ... , vp} als je b kunt schrijven als = c1 * v1 + c2 * v2 + … + cp + vp.

Dus om te kijken of b er in zit, moet c1 * v1 + c2 * v2 + … + cp * vp = b oplossingen hebben.

Dit los je op door c1 * v1 + c2 * v2 + … + cp * vp = b te beschouwen als vectorvergelijking (en

die is weer oplosbaar door hem als aangevulde matrix te schrijven).

Logisch equivalente beweringen: (zie aantekening voor uitleg!)

1. Voor elke b in Rm heeft de vergelijking Ax = b een oplossing

2. Elke b in Rm is een lineaire combinatie van de kolommen van A

3. De kolommen van A spannen Rm op

4. A heeft een pivot positie in elke rij

Rekenregels: Als A een m x n matrix is, u en v vectoren in Rn en c een scalair, dan

• A(u + v) = Au + Av

• A(cu) = cAu

Lineaire combinaties

• x1*a1

• Ax (= x1*a1 + x2*a2 + …)

Homogeen systeem: Ax = 0

• Altijd de triviale oplossing x = 0

• Soms zijn er niet-triviale oplossingen voor x (dan is er een vrije variabele in de

oplossingsverzameling van x aanwezig)

o Als er niet-triviale oplossingen zijn, dan is het systeem lineair afhankelijk

o Als er geen niet-triviale oplossingen zijn, dan is het lineair onafhankelijk

Niet-homogeen systeem: Ax = b

(DIT IS GEEN EERSTEGRAADS FUNCTIE!)

• Heeft de oplossing x = [x1; x2; x3 …] (de puntkomma tussen de x-en betekent dat de xen eigenlijk onder elkaar moeten staan, maar dat is geen efficiënt papiergebruik). Door

op de plaatsen van x1, x2, x3 enz. de gevonden waarden (na het herleiden van de

aangevulde matrix) in te vullen, kun je x herschrijven tot x = [x1; x2; x3 …] = p + vh.

Hierbij is vh de niet-triviale oplossing van het homogeen systeem. p is een vector die

er voor zorgt dat de oplossing gaat gelden voor Ax = b. Geometrisch gezien zorgt p er

voor dat de oplossingsverzameling verschoven wordt. vh wordt ook wel de homogene

oplossing genoemd en p de particuliere oplossing.

De volgende dingen kunnen lineair afhankelijk zijn (controleren m.b.v. aangevulde matrices):

• Matrix kolommen, als een kolom een veelvoud is van een andere kolom

• Homogene systemen: Ax = 0

• Verzamelingen: { v1, v2, ... , vp } = c1 * v1 + c2 * v2 + … + cp * vp = Ax = 0

o Verzameling S = { v1, v2, ... , vp } is ook lineair afhankelijk als geldt:

v2 = c * v 1

Als één van de vectoren de nulvector is

Als er meer vectoren zijn dan rijen in een vector (dus p>n)

vp is een lineaire combinatie van andere vectoren (c1*v1 + c2*v2 = vp)

(lineaire combinatie, want bovenstaande is herschrijfbaar tot: Ax = b)

Transformatie T

• T zet vector x om in vector b = T(x)

• Hierbij gaat x van Rn naar Rm

• Rn is het domein van T

• Rm is het codomein van T

• T(x) noemen we ook wel het beeld van x onder T ,dus T(u) is het beeld van u onder T

• T(x) is het bereik van T, en dit is gelijk aan de verzameling van alle beelden onder T

Injectief/surjectief:

• Een afbeelding T: Rn -> Rm heet surjectief (engels: “onto”) als elke willekeurige

vector b = T(x) in Rm het beeld is van MINSTENS 1 vector x in Rn.

•

Een afbeelding T: Rn -> Rm heet injectief (engels: “one-to-one”) als elke willekeurige

vector b in Rm het beeld is van HOOGUIT 1 vector x in Rn.

Soorten transformaties:

• Lineaire transformaties: deze voldoen aan de volgende rekenregels:

o T(u+v) = T(u) + T(v) voor alle u, v in het domein van T (in Rn dus)

o T(cu+dv) = c*T(u) + d*T(v) voor alle u, v in het domein van T (in Rn dus)

o T(c*u) = c*T(u)

voor alle u alle c

o T(0) = 0

• Matrix transformaties (meest gebruikte). hiermee zet je met behulp van een matrix A

de vector x om in b, T(x) = Ax = b. Matrix transformaties zijn lineaire transformaties.

Soms heb je te maken met de transformatie T(x) = Ax en dan is A gevraagd, zodat je

T(x) voor elke willekeurige x kunt berekenen. Dan is er in zo’n vraag e1, e2 enz.

gegeven met bijbehorende T(e1), T(e2) enz. Dan A= [ T(e1) T(e2) … enz. ]

A heet dan de standaard matrix voor de lineaire transformatie T. Uitgebreide uitleg en

het bewijs van de stelling in de aantekening bij paragraaf 1.9

• Geometrisch lineaire transformaties: dit zijn lineaire transformaties die beschreven

worden in een assenstelsel. De volgende dingen kunnen gebeuren:

o Een punt/vlak verschuiven (= schuiftransformatie). Dit kan met een

willekeurige matrix A ( T(x) = Ax ), maar ook met een scalair r ( T(x) = r*x ).

Als 0<r<1, dan wordt de afbeelding verkleind en dan spreek je van contractie.

Als r>1, dan wordt de afbeelding vergroot en dan spreek je van dilatie.

o Een punt verschuiven over een cirkel. Bijbehorende matrix op pagina 100.

o Een punt spiegelen, bijvoorbeeld in de x-as, de y as, de lijn y=x, de lijn y=-x of

de oorsprong. Bijbehorende standaardmatrices op pagina 101 van het boek.

o Een vlak projecteren op de x-as of y-as. Bijbehorende standaardmatrices op

pagina 103 van het boek.

Hoofdstuk 2: Matrix Algebra Rekenregels voor matrices:

• A+B=B+A

• (A + B) + C = A + (B + C)

• A+0=A

• r*(A + B) = r*A + r*B

• (r+s)*A = r*A + s*A

• r*(s*A) = (r*s)*A

• A*B ≠ B*A

OPLETTEN DUS!

• A*B = [A*b1 A*b2 A*b3 … A*bn] en B*A = [B*a1 B*a2 B*a3 … B*an]

Alle kolommen A*bn van matrix A*B zijn dus lineaire combinaties (Ax = b = A*bn)

• Als A is een m x n matrix en B een n x p matrix, dan is AB een m x p matrix

• Ak = A*A*A*…*A (bijv. A3 = A*A*A)

• A(BC) = (AB)C

• A(B+C) = AB + AC

• (B+C)A = BA + CA

• r(AB) = (rA)B = A(rB)

• Im*A = A = A*In

LET OP DE VOLGORDE VAN A EN I en Im EN In

• Als AB = AC, dan geldt NIET automatisch B=C

• Als A*B = 0, dan geldt NIET automatisch A=0 of B=0

AT is de transpose van matrix A. We zeggen dan dat we matrix A transponeren. In matlab is

dit A’. Hiermee worden de rijen kolommen en de kolommen worden de rijen. Ook hiervoor

gelden een aantal rekenregels:

• (AT)T = A

• (A+B)T = AT + BT

• (rA)T = r*AT

• (ABC)T = CTBTAT

LET WEER OP DE VOLGORDE VAN A EN B

De inverse matrix van A is A-1. Dit is een unieke matrix. Matrices die geen iverse hebben

heten singulier. Matrices die wel een inverse hebben noemen we niet-singulier. Alleen

vierkante matrices kunnen geïnverteerd worden (A is dus een n x n matrix) en de inverse

matrix bestaat alleen wanneer A*A-1 = A-1*A = In

De inverse matrix van A vind je door de matrix [A I] te herleiden. Het resultaat wordt dan

[I A-1]. Nu kun je de oplossing zo aflezen uit het achterste gedeelte A-1.

Voor een 2x2 matrix is er nog een andere manier:

Als A = [a b

c d]

dan A-1 = 1/(ad – bc) * [d –b

-c a]

waarbij (ad – bc) = det A

(determinant van A)

De matrix In noemen we een identiteitsmatrix. Dit is een vierkante matrix met n rijen en n

kolommen.

Rekenregels m.b.t. inverse matrices:

• Als Ax = b, dan x = A-1b (alleen als A-1 bestaat)

• Als A inverteerbaar is, dan is A-1 ook inveerteerbaar

• (AB)-1 = B-1A-1

• (AT)-1 = (A-1)T (Als A inverteerbaar is, dan is AT ook inverteerbaar)

De volgende stellingen zijn logisch equivalent voor een n x n matrix A:

• A is een inverteerbare matrix

• A is rij-equivalent (~) aan In (dus A is te herleiden tot In)

• A heeft n pivot posities (dit is een mooie controle op inverteerbaarheid)

• Ax = 0 heeft alleen de triviale oplossing (geen vrije variabelen in A)

• De kolommen van A vormen een lineair onafhankelijke verzameling

• The lineaire transformatie T(x) = Ax is injectief (one-to-one)

• Ax = b heeft minstens 1 oplossing voor elke b in Rn

• De kolommen van A omspannen Rn

• De lineaire transformatie T(x) = Ax beeld Rn af in Rn

• Er is een matrix C zodat CA = I

• Er is een matrix D zodat AD = I

• AT is een inverteerbare matrix

Ook lineaire transformaties kunnen inverteerbaar zijn. Stel je transformeert x naar T(x) door

A*x, dan kun je T(x) terug transformeren naar x door T(x)*A-1 (A*x*A-1 = x)

Een elementaire matrix E is een matrix die ontstaat door één enkele elementaire rij-operatie

uit te voeren op een eenheidsmatrix. Omdat rij-operaties omkeerbaar zijn (en E dus weer terug

te schrijven is tot I) zijn alle elementaire matrices inverteerbaar. De inverse matrix E-1 is de

elementaire matrix die E terug transformeert naar I.

Het Leontief input-output model is een rekenmethode die in de economie wordt gebruikt om

de verdeling te bepalen van geproduceerde goederen:

Totale productie = Onderlinge vraag tussen bedrijven + vraag consument

x

=

Cx

+

d

Waarbij x de totale productie is, C de matrixvorm van de input-output tabel, en d de vraag van

de consument. Vaak wordt deze formule herschreven tot de vorm: (I-C)x = d , waardoor x

oplosbaar wordt. Hier staat namelijk gewoon Ax = b.

Bij benadering geldt: (I-C)-1 ≈ I + C + C2 + C3 + … + Cm als de waarden in de kolommen van

C kleiner zijn dan 1. Wanneer dan m naar oneindig gaat, nadert Cm de nul-matrix.

Voorbeeld Col A (Zie volgende bladzijde) en Rij A

Een apart type opspansel is de deelruimte. Een deelruimte H voldoet aan de volgende eisen:

• H bevat de nulvector

• Voor elke willekeurige u en v, de som u + v ligt in deelruitme H

• Voor elke willekeurige u en elke willekeurige scalair c, het product c*u ligt in H

Een basis voor een deelruimte H van Rn is een lineair onafhankelijke verzameling in H die

H opspant. Dus je moet kijken of de gegeven kolommen lineair onafhankelijk zijn.

Logisch equivalente beweringen voor vierkante (n x n) matrices:

1. Voor elke b in Rm heeft de vergelijking Ax = b een oplossing

2. Elke b in Rm is een lineaire combinatie van de kolommen van A

3. De kolommen van A spannen Rm op (dus de kolommen zijn een basis voor Rm)

4. A heeft een pivot positie in elke rij

5. De kolommen van A zijn lineair onafhankelijk

6. A is een inverteerbare matrix

7. A is herleidbaar tot de identiteitsmatrix Im

Col A (“Kol A” in het Nederlands) is de kolomruimte (of de afbeelding / image) van matrix

A. Dit is de verzameling van alle lineaire combinaties van de kolommen van A. Om te kijken

of een bepaalde vector v in Col A voorkomt, los je op: Ax = v. Is dit systeem consistent, dan

zit v in Col A.

• Col A: Als A = [a1 a2 … ], dan Col A = Ax = Span{ a1, a2, …} = x1*a1 + x2*a2 + …

• De basis voor Col A bestaat uit de pivot kolommen van de originele matrix A, en dus

niet van de gereduceerde vorm van A

Nul A is de nulruimte (of kernel) van matrix A. dit is hetzelfde als de oplossingsverzameling

van Ax = 0. Om te kijken of een bepaalde vector v in Nul A voorkomt, moet je A*v

uitrekenen en kijken of dit de nulvector oplevert. Zo ja, dan zit v in Nul A, en anders niet.

• Nul A = de oplossingsverzameling van Ax = 0

• De basis voor Nul A bestaat uit de vectoren in de oplossingsverzameling van Ax = 0,

dus als Nul A = x3*u + x4*v, dan de basis voor Nul A = {u,v}

Met de dimensie van een deelruimte H bedoelen we het aantal vectoren in de basis van H.

De rang van matrix A is de dimensie van Col A (dus het aantal vectorkolommen in de basis

van Col A). Dus: Rang A = dim Col A. Ook geldt voor m x n matrix A: dim Col A + dim

Nul A = n

Hoofdstuk 3: De determinant De determinant van een matrix is een getal dat vertelt of een matrix inverteerbaar is of niet.

Als det A (de determinant van A) gelijk is aan nul, dan is de matrix niet inverteerbaar. A heet

dan singulier.

Is de determinant ongelijk aan nul, dan is de matrix wel inverteerbaar, en is A niet-singulier.

Omdat alleen vierkante matrices inverteerbaar kunnen zijn, hebben ook alleen vierkante

matrices een determinant. Van een 1x1 en een 2x2 matrix kunnen we de determinant direct

berekenen (Zie vorige bladzijde).

Voor het berekenen van de determinant van grotere matrices bestaan 2 technieken:

• cofactor ontwikkeling naar een bepaalde rij of kolom.

• De matrix omschrijven tot de driehoeksmatrix. De determinant is vervolgens gelijk

aan het product van de getallen in de hoofddiagonaal. Denk met omschrijven aan de

rekenregels voor elementaire rij-operaties.

Tekenafspraak:

Driehoeksmatrices:

Andere notatie:

Enkele standaard determinanten:

• 1x1 matrix: det A = a

(met A = [a])

• 2x2 matrix: det A = ad – bc

• Driehoeksmatrix: det A = Het product van de getallen op de hoofddiagonaal

• Identiteitsmatrix: det In = 1

• Matrix met twee dezelfde rijen: det A = 0

• Matrix met nulrij: det A = 0

• Matrix met nulkolom: det A = 0

• det AT = det A

• det A-1 = 1/(det A)

• det (A*B) = (det A)*(det B)

• det (A4) = (det A) * (det A) * (det A) * (det A)

• LET OP: det (A+B) ≠ (det A) + (det B)

De determinant na elementaire rij-operaties:

• Als de matrix B ontstaat door een veelvoud van een rij van A op te tellen bij een

andere rij, dan: det B = det A

• Als B ontstaat door twee rijen van A te verwisselen, dan: det B = −det A

• Als B ontstaat door een rij van A met k te vermenigvuldigen, dan: det B = k * det A

De determinant na kolom-operaties:

• Als de matrix B ontstaat door een veelvoud van een kolom van A op te tellen bij een

andere kolom, dan: det B = det A.

• Als B ontstaat door twee kolommen van A te verwisselen, dan: det B = −det A.

• Als B ontstaat door een kolom van A met k te vermenigvuldigen, dan: det B= k*det A.

De lineariteit eigenschap van een determinant houdt in dat je de determinant kunt zien als een

lineaire functie van de kolom variabele. Verder geen idee wat je er mee kunt!

Regel van Cramer: xi = det Ai(b) / det A

met Ai(b) Matrix A waarbij de i-de kolom

vervangen is door b.

De geadjungeerde van Matrix A, genoteerd als adj A, is de matrix die uit cofactoren bestaat:

(Vraag 11 van paragraaf 3.3 bestuderen!)

In dit voorbeeld zijn de cofactoren voor linksboven en linksonder aangegeven. Let ook hier

weer op de tekenafspraak!

Enkele toepassingen van de determinant:

•

De oppervlakte van een parallellogram is de absolute waarde van de uitkomst van

de determinant van de vectoren van de 2 belangrijkste hoekpunten, dus:

oppervlakte = | det A |

Hierbij is A dus een 2 x 2 matrix. Voorwaarde is wel dat 1 van de 2 onbelangrijke

hoekpunten de oorsprong is. Is dit niet zo, dan moet je het parallellogram verschuiven

zodat hij in de oorsprong komt.

•

Het volume van een blok wordt bepaald door de absolute waarde van de uitkomst van

de determinant van de vectoren van de 3 belangrijkste hoekpunten, dus:

volume = | det A |

Hierbij is A dus een 3 x 3 matrix. Ook hier weer de voorwaarde dat 1 van de

hoekpunten de oorsprong is.

Hoofdstuk 4: Vectorruimtes Een vectorruimte is een meer gangbare naam voor een deelruimte. Zodra je echter met 2

vectorruimten te maken hebt, waarvan de ene vectorruimte (bijv. H) binnen de tweede

vectorruimte (bijv. V) valt, dan noemen we H een deelruimte van de vectorruimte V. Hierbij

moet wel opgemerkt worden dat H alleen een deelruimte van een vectorruimte genoemd mag

worden als geldt dat:

• De nulvector zit in H

• u + v zit in H

• cu zit in H

Normaal gesproken ben je gewend om de coördinaten van een assenstelsel uit te drukken in

(x,y). Dan werk je in vectorruimte R, met als basis { (1 0) , (0,1) } voor R2.

Maar je kunt ook met vectoren werken, bijv. b1 en b2, die een opspansel of deelruimte

vormen. Een punt binnen deze deelruimte druk je dan uit in bijv. 3b1 en 2b2. Als je het punt x

uit wil drukken in vectoren, doe je dat met [x]B. Hierin is B de verzameling vectoren die de

basis van de desbetreffende deelruimte vormen. Hieronder een voorbeeld:

Dit kun je ook zien als een vector [x]B die uitgedrukt staat in coördinaten van de basis van

deelruimte V. Wil je deze vector nu in omschrijven naar de vector x (in de gewone xycoördinaten), dan vermenigvuldig je [x]B met de change-of-coordinates matrix PB = [b1 b2].

In formule-vorm geldt: PB [x]B = x. Ook geldt: PB-1 x = [x]B

Met deze injectieve lineaire transformatie kun je deelruimte V dus op Rn projecteren.

Een deelruimte H kan beschreven worden in één grote vector met een aantal variabelen, bijv.

Als je een basis wilt weten voor deze deelruimte, moet je deze vector ontleden in losse

vectoren per variabele. De basis voor de deelruimte is dan de verzameling lineair

onafhankelijke vectoren die hier uitkomt. De basis voor H is [b1 b2].

Een tweede type deelruimte is P.. Hierdoor los je de constanten op die bij polynome functies

horen (§ 4.4 opg. 13). Een polynoom beschrijf je als volgt:

1

2

3

. De graad van polynomen geven we aan met Pn, net zoals je de dimensie van een

vector aangeeft met Rn. P geeft dus ook een vectorruimte weer, net zoals R. De basis voor Pn

is [1 t t2 … tn].

Een derde type vectorruimte is S. Dit zijn alle getallen afkomstig uit alle oneindige rijen. Een

oneindige rij wordt ook wel een signaal gemoend. In de vectorruimte S komen dus meerdere

oneindige rijen (signalen) voor. Een basis voor S met één signaal is {yk}. Een basis voor S

met 3 lineair onafhankelijke signalen is {uk vk wk}. Om te testen of deze 3 signalen ook echt

lineair onafhankelijk zijn, moet gelden dat c1uk + c2vk + c3wk = 0 voor álle k.

Hierdoor kun je gewoon een matrix maken, de zogenaamde Casorati matrix, waarbij je net

zo vaak k invult als dat je signalen hebt, bijv.

Als deze matrix in elke rij een pivot positie heeft, weet je dat de signalen lineair onafhankelijk

zijn.

Een vierde type vectorruimte is de complexe ruimte Cn. Deze bevat alle reële en complexe

vectoren. In hoofdstuk 5 komt deze vectorruimte aan bod.

Een vijfde type is de functieruimte F(R,R). Deze ruimte bevat alle functies f(x), waarbij f en

x elementen zijn van R. In F(R,R) zitten bijvoorbeeld f(x) = x, f(x) = x2, f(x) = ex enz. Naast

F(R,R) zijn hier ook andere varianten van, zoals F(R,C), die een reëel getal x afbeeld op een

complexe f(x).

Een zesde type ruimte is de ruimte Mk,n(C). Dit is de verzameling van alle complexe k x n

matrices.

Voor het analyseren van discrete data kun je gebruik maken van differentievergelijkingen.

Een voorbeeld van een differentievergelijking is: 3yk+2 + 4yk+1 + 5yk = 3.

Om dit op te lossen moet je onderscheid maken tussen de homogene en de particuliere

oplossing.

Voor de homogene oplossing vervang je het rechterlid door nul, en probeer je yk = rk. Dit

geeft als resultaat: yk = c1*r1k + c2*r2k. Dit kun je ook zien als { r1k , r2k}, dus een basis voor S.

Vervolgens moet je een particuliere oplossing zoeken. Hier is geen systematische aanpak

voor, maar normaal gesproken staat er in het rechterlid een constante, en dan kies je als

particuliere oplossing yp = K, en los je K op door invullen. (3K + 4K + 5K = 3 => K = 0,25)

Hoofdstuk 5: Eigenvectoren en eigenwaarden In hoofdstuk 1 heb je geleerd dat je een vector x met behulp van een lineaire transformatie een

andere waarde kunt geven, namelijk Ax. Soms komt deze nieuwe waarde Ax neer op een

veelvoud van de oorspronkelijke vector x, dus Ax = λx. Als dit zo is, dan is λ een

eigenwaarde van matrix A, en de bijbehorende vector x is een eigenvector van A.

Om te controleren of een willekeurige λ een eigenwaarde is van een matrix A, moet je de niettriviale oplossingen van de vergelijking (A-Iλ)x = 0 oplossen. Niet-triviale oplossingen

bestaan als de matrix (A-Iλ) niet-inverteerbaar is, dus om de eigenwaarden van een matrix A

op te sporen, moet je de karakteristieke vergelijking det(A – Iλ) = 0 oplossen. Een matrix

met determinant nul is namelijk niet inverteerbaar, waardoor Ax niet-triviale oplossingen

krijgt (en dan bestaan er ook eigenvectoren).

Het eerste gedeelte van de karakteristieke vergelijking, namelijk det(A– Iλ), wordt het

karakteristieke polynoom genoemd.

Als de eigenwaarden eenmaal gevonden zijn, kunnen deze waarden voor λ weer ingevuld

worden in de vergelijking (A-Iλ)x = 0. Hier komen nu altijd niet-triviale oplossingen uit.

Deze niet-triviale oplossing bestaat uit een lineaire combinatie van scalairen en vectoren, die

eigenvectoren worden genoemd. Deze lineaire combinatie is tevens een basis voor de

eigenruimte, die we noteren met Eλ(R), waarbij je voor λ de eigenwaarde invult en R staat

voor de verzameling reële getallen. Eén matrix kan dus meerdere eigenruimten hebben, want

voor elke eigenwaarde is er een eigenruimte. Bij één eigenwaarde kunnen dus meerdere

eigenvectoren horen (als er 2 of meer vrije variabelen in de oplossingsverzameling zitten).

BELANGRIJK:

• De nulvector telt niet mee als eigenvector, maar de eigenwaarde λ = 0 telt wel mee!

• De eigenwaarden van een driehoeksmatrix zijn de getallen op de hoofddiagonaal.

• Als matrix A lineair afhankelijke kolommen heeft, is λ = 0 een eigenwaarde.

• Een verzameling vectoren {v1 v2 … vr } is lineair onafhankelijk als ze allemaal een

unieke eigenwaarde hebben.

Om te controleren of een bepaalde vector een eigenvector van matrix A is, dan moet je de

matrix en de vector met elkaar vermenigvuldigen, en als het resultaat een veelvoud is van de

vorige vector, dan weet je dat het om een eigenvector gaat.

Naast de reële ruimte Rn bestaat er ook een complexe ruimte Cn. Sommige matrices die uit

reële getallen bestaan hebben complexe eigenwaarden met bijbehorende complexe

eigenvectoren in een complexe eigenruimte. Deze complexe eigenschappen kunnen worden

gebruikt om bepaalde eigenschappen van geliniariseerde systemen te achterhalen, zoals

periodieke beweging (bijv. de differentiaalvergelijking van de slinger bij dynamica I).

TRUCJE (§ 5.5 opgave 1): Vaak heb je te maken met simpele 2x2 matrices. Dit is een

voordeel omdat je dan niet hoeft schoon te vegen met complexe getallen in de aangevulde

matrix. De bovenste en onderste vergelijking zullen namelijk toch hetzelfde opleveren als er

een in de 2x2 matrix een eigenwaarde bij wordt gezet. Hierdoor kun je de simpelste van de 2

vergelijkingen eruit pikken, en aan de hand daarvan de vector x bepalen.

Als je van een matrix A een veelvoud Ak moet berekenen is het handig om te kijken of je A

kunt diagonaliseren. Dit houdt in dat je stelt dat A = PDP-1. Hierin is D de diagonale matrix

met alleen op de hoofddiagonaal getallen, en voor de rest allemaal nullen. P en P-1 zijn de

matrices die ervoor zorgen dat D omgezet kan worden in A. Het voordeel van deze notatie is

dat nu geldt dat Ak = PDkP-1. Je hoeft dus alleen maar de getallen in D tot de macht k te doen.

Een niet-diagonaliseerbare matrix noemen we defect. Een n x n matrix A is namelijk alleen

diagonaliseerbaar als deze n lineair onafhankelijke eigenvectoren heeft. De bijbehorende

eigenwaarden van deze eigenvectoren staan op de hoofddiagonaal van de matrix D. Op hun

beurt staan de eigenruimten van deze eigenvectoren in de matrix P. Tenslotte wordt P-1

berekend door de inverse matrix van P te berekenen.

Bij het analyseren van discrete dynamische systemen gebruik je een toestandsvector xk. In

deze vector staan alle waarden van de te analyseren toestanden. In xk staan bijvoorbeeld het

aantal uilen op tijdstip k (x1) en het aantal ratten op tijdstip k (x2), waarbij k het aantal

maanden aangeeft. Met behulp van een formule voor xk kun je nu op elk tijdstip het aantal

uilen en ratten berekenen. algemene formule: xk = c1(λ1)kv1 + c2(λ2)kv2 + … + cn(λn)kvn. Hierin

is c een constante die je kunt bepalen als x0 gegeven is. Alle λ’s zijn eigenvectoren van een

matrix A, en de v’s zijn de eigenvectoren die bij de eigenwaarden horen. De matrix A is zo

opgesteld zodat geldt dat xk+1 = Axk.

Vaak wordt om het lange-termijn gedrag van zo’n discreet systeem gevraagd. Dit betekent dat

je moet bepalen wat er gebeurt als k naar oneindig gaat. Als dit gebeurt, dan zullen alle

eigenwaarden die kleiner zijn dan 1 geen invloed meer hebben, want (0,…)k gaat dan naar

nul. Hierdoor hou je meestal nog maar één term over, zodat je een simpele uitdrukking krijgt,

zoals xk+1 = 3xk.

Ten slotte moet hier opgemerkt worden dat dit een vorm van differentievergelijkingen zijn,

bijvoorbeeld als xk = c1(λ1)kv1, dan geldt dat xk+1 = c1(λ1)k+1v1 = λ1*c1(λ1)kv1 = λ1* xk. Dus yk

= λk is ook hier een oplossing, want yk+1 = λk+1 = λ*λk = λ*yk

Bij het analyseren van continue data kun je gebruik maken van differentiaalvergelijkingen. De

algemene oplossing hiervoor is t

c e

c e

… c e

Hierbij noemen we e

e

…

e de eigenfuncties van A.

Hierin is c een constante die je kunt bepalen als x0 gegeven is. Alle λ’s zijn eigenwaarden van

een matrix A, en de v’s zijn de eigenvectoren die bij de eigenwaarden horen. De matrix A is

zo opgesteld zodat geldt dat x’ = Ax.

Indien er complexe eigenwaarden ontstaan, krijg je ook een complexe e-macht in de

oplossing. Deze kun je splitsen in een reëel deel en een complex deel, waarbij je het complexe

deel vervangt:

LET OP: als je te maken hebt met complexe oplossingen, hoef je bij 2x2 matrices alleen

maar de eigenfunctie x1(t) op te lossen, want deze geeft als resultaat al een antwoord met 2

lineair onafhankelijke vectoren er in (namelijk een reëel en complex deel). Het oplossen van

x2(t) heeft in dit geval geen nut. Dit komt omdat x2(t) de complex geconjugeerde is, en het

oplossen van dit gedeelte levert geen nieuwe lineair onafhankelijke vectoren op.

Het spoor (trace) van een vierkante n x n matrix A is de som van de getallen op de

hoofddiagonaal, dus tr(A) = a11 + a22 + … + ann.

Hoofdstuk 6 (§ 6.1 t/m § 6.4): Orthogonaliteit

Inproduct:

Lengte van een vector:

Een vector met lengte 1 heet een eenheidsvector (let op: ei heet óók een eenheidsvector)

De afstand tussen twee vectoren is ||u-v||:

Uitproduct (= kruisproduct):

Grafische voorstelling van het uitproduct:

Hieruit volgt: De vector u x v is orthogonaal tot zowel u als v.

Het uitproduct bestaat alleen voor vectoren in R3.

Als hoek θ nu 90° is, en u en v dus orthogonaal zijn, dan: u · v = ||u|| ||v|| cos( ½π) = 0

Als hoek θ nu 0° is, en u en v dus parallel lopen, dan: u · v = ||u|| ||v|| cos (0) = ||u|| ||v||

Rekenregels voor in- en uitproduct:

• u·v=v·u

• (u + v) · w = u · w + v · w

• (cu) · v = u · (cv)

• u · u ≥ 0 (behalve als u = 0 natuurlijk)

• (c1*u1 + … + cpup) · w = c1(u1 · w) + … + cp(up· w)

• || cu || = c ||u||

• u x v = -v x u

• (cu) x v = c(u x v) = u x (cv)

• u x (v + w) = u x v + u x w

• (u + v) x w = u x w + v x w

• u · (v x w) = (u x v) · w

• u x (v x w) = (u · w)v – (u · v)w

Enkele toepassingen van in- en uitproduct:

• De oppervlakte van een parallellogram dat wordt bepaald door u en v is gelijk aan

de lengte van het uitproduct van u en v, dus opp. = ||u x v||

• Het volume van een blok dat wordt bepaald door u, v en w is gelijk aan | u · (v x w) |

(De verticale strepen zijn absoluutstrepen)

Een verzameling vectoren S = {u1 u2 u3 … up} heet orthogonaal als het inproduct van 2

willekeurige vectoren uit deze verzameling altijd nul oplevert. Deze vectoren zijn dan lineair

onafhankelijk en vormen een basis voor deelruimte S.

Een verzameling vectoren heet orthonormaal als de verzameling orthogonaal is en als alle

vectoren eenheidsvectoren zijn (dus met lengte 1). Een orthogonale verzameling kun je

omzetten in een orthonormale verzameling door alle vectoren te delen door hun eigen lengte.

De verzameling van vectoren z die orthogonaal zijn tot vlak W, waarbij W omspannen wordt

door u en v, heet het orthogonaal complement van W en wordt genoteerd met W┴. Een

vector x zit in W┴ als x orthogonaal is ten opzichte van élke vector in de verzameling

vectoren die W opspant.

De ruimtes W en W┴ zijn tevens deelruimten van Rn.

Als A een m x n matrix is, dan is het orthogonaal complement van de rijruimte van A de

nulruimte van A, en het orthogonaal complement van de kolomruimte van A is de nulruimte

van AT: (Rij A) ┴ = Nul A en (Kol A) ┴ = Nul AT

Soms is het handig een vector te ontbinden in 2 orthogonale vectoren, bijv. een kracht F die je

ontbindt in een Fx en een Fy, waarbij Fx en Fy orthogonale vectoren zijn. Vaak noemen we

de oorspronkelijke vector y, de eerste vector u (de getallen in deze vector mag je vrij kiezen)

en de tweede vector z (z staat dus orthogonaal op u). Nu is y dus te schrijven als lineaire

combinatie van u en z, dus

. De coëfficiënten c1 en c2 van deze (en elke

·

·

andere) orthogonale basis vind je als volgt:

en

.

·

·

Het eerste gedeelte van de formule van y noemen we de orthogonale projectie van y op u,

symbool , dus

.

Het tweede gedeelte kun je nu ook gemakkelijk te vinden, want dit is gelijk aan

, dus

.

Als je te maken hebt met vectoren die maar 2 getallen bevatten, kun je de bijbehorende

orthogonale vector nog sneller vinden. Je maakt dan namelijk de tweede vector door van de

eerste vector het bovenste en onderste getal om te draaien, en vervolgens moet je één van die

twee getallen met -1 vermenigvuldigen.

Hierboven staat beschreven hoe je een vector y orthogonaal kunt projecteren op een vector u.

Naast het projecteren op een vector, kun je ook op vlakken (of ruimtes met nog meer dan 2

diimensies) projecteren. Bijvoorbeeld het bovenaanzicht van een 3D pijl is een orthogonale

projectie van een vector op een vlak. Hierbij beschrijf je het vlak als een opspansel van 2

orthogonale vectoren die de basis voor dit vlak vormen, dus Span{u1 u2}. Stel dat je een

vector y beschrijft als y = c1u1 + c2u2 + c3u3 , dan ga je deze vector splitsen in y = z1 + z2, met

z1 = = c1u1 + c2u2 (elementen uit W) en z2 = c3u3 (elementen uit W┴). De bijbehorende

·

constanten kun je weer uitrekenen met de formule

. De orthogonale projectie van y

·

op W wordt ook wel de beste benadering van y in W genoemd.

Met behulp van het Gram-Schmidt proces kun je orthogonale bases vinden voor

deelruimten in Rn. Dit doe je door een paar keer achter elkaar een vector orthogonaal te

projecteren (hierboven beschreven). Je begint met vector v1 die je gelijkstelt aan de eerste

gegeven vector x1. Vervolgens ga je vector x2 orthogonaal projecteren op vector v1, waardoor

je

krijgt. De afstand tussen x2 en

noem je vector v2. Het mooie hiervan is dat v2

orthogonaal staat op v1. Nu vormen v1 en v2 een deelruimte in R2 (een vlak dus). Vervolgens

pak je vector x3 die je orthogonaal projecteert op het vlak met orthogonale basis {v1 v2}.

noem je vector v3. Nu vormen de vectoren

Hierdoor ontstaat . De afstand tussen x3 en

3

v1, v2 en v3 een deelruimte in R met orthogonale basis {v1 v2 v3}.

Op deze manier ga je net zolang door totdat je alle vectoren x1 … xn gebruikt hebt. Op deze

manier kun je dus van de deelruimte die opgespannen wordt door de vectoren x1 … xn een

orthogonale basis vinden die bestaat uit de orthogonale vectoren v1 … vn.

Vervolgens kan de orthogonale basis {v1 … vn} nog worden omgezet in een orthonormale

basis {u1 … un} door alle vectoren te delen door hun eigen lengte, dus

|

Het Gram-Schmidt proces in formulevorm:

•

·

•

•

•

•

…

·

·

·

·

·

·

·

·

·

...

·

·

|